Weet je niet zeker wat een robots.txt bestand is en hoe het een belangrijke rol speelt in SEO? Of je nu de eigenaar bent van een klein bedrijf, een digitale marketeer, of een SEO-liefhebber, als je de werking van robots.txt beter begrijpt kan dit enorm belangrijk zijn in hoe je website geïndexeerd wordt en verschijnt in zoekmachines.

Eigenlijk is robots.txt een eenvoudig tekstbestand dat zoekmachine bots vertelt hoe ze de pagina’s op je website moeten crawlen en indexeren. Zie het als een soort routekaart die deze bots naar de essentiële pagina’s leidt en ze wegleidt van de secties die je liever verborgen houdt. Deze gids maakt het potentieel lastige onderwerp van robots.txt voor jouw een stuk makkelijker en geeft duidelijke, bruikbare stappen om deze te optimaliseren voor zoekmachines.

We beginnen met de basis: wat is robots.txt? Daarna lopen we met je door voorbeelden van robots.txt bestanden, en illustreren we hun structuur en syntaxis. Met deze basiskennis leer je hoe je je robots.txt bestand maakt en, nog belangrijker, test om er zeker van te zijn dat het werkt zoals bedoeld.

Maar daar laten we het niet bij. De ware kracht van een goed ontworpen robots.txt bestand ligt in de optimalisatie ervan. Daarom duiken we ook in de optimalisatie van robots.txt, en onthullen we vakkundige strategieën om dit krachtige hulpmiddel te maximaliseren.

TL;DR: Een robots.txt bestand begeleidt de bots van zoekmachines bij het crawlen en indexeren van je site. Het maken en optimaliseren van dit bestand om de SEO van je site te verbeteren is essentieel. Deze gids geeft een uitgebreid inzicht in robots.txt, compleet met voorbeelden en optimalisatietips.

Het maakt niet uit of je een SEO beginner bent of een ervaren pro, deze gids staat vol met waardevolle inzichten. En vergeet niet, als je ooit professionele hulp nodig hebt, staat ons team van User Growth altijd voor je klaar. Dus, laten we erin duiken en samen het mysterie van robots.txt ontrafelen!

Table of Contents

- Wat is een robots.txt bestand?

- Waarom is Robots.txt belangrijk?

- Robots.txt syntax

- De User-Agent richtlijn

- De Disallow richtlijn

- De toestaan-richtlijn

- De Sitemap-richtlijn

- Crawl-Delay richtlijn

- Noindex richtlijn

- Hoe maak je een robots.txt bestand en test deze?

- Je robots.txt bestand optimaliseren

- Robots.txt Best Practices

- Gebruik nieuwe regels voor elke richtlijn

- Gebruik elke user-agent één keer

- Wildcards gebruiken om aanwijzingen te verduidelijken

- Gebruik "$" om het einde van een URL aan te geven

- Gebruik de Hash (#) om commentaar toe te voegen

- Gebruik aparte robots.txt bestanden voor verschillende subdomeinen

- Conclusie

- Veelgestelde vragen over Robots.txt

- Wat is robots.txt, en hoe werkt het?

- Hoe kan robots.txt mij helpen de toegang van zoekmachine-crawlers tot mijn website te controleren?

- Wat zijn de voordelen van het gebruik van robots.txt, en hoe kan het de SEO van mijn website verbeteren?

- Kan robots.txt gebruikt worden om specifieke zoekmachines of bots te verhinderen mijn website te crawlen?

- Wat zijn veel voorkomende fouten die je moet vermijden bij het maken van een robots.txt bestand?

- Wat gebeurt er als ik geen robots.txt bestand op mijn website heb?

- Hoe test ik mijn robots.txt bestand om er zeker van te zijn dat het correct werkt?

- Kan ik robots.txt gebruiken om te voorkomen dat specifieke pagina's of delen van mijn website door zoekmachines worden geïndexeerd?

- Hoe kan ik mijn robots.txt bestand aanpassen aan veranderingen in de structuur of inhoud van mijn website?

- Wat is het verschil tussen "allow" en "disallow" directives in robots.txt?

- Hoe kan ik wildcards in robots.txt gebruiken om de toegang tot meerdere URL's of mappen te blokkeren of toe te staan?

- Wat is de syntaxis voor robots.txt, en hoe kan ik ervoor zorgen dat het goed geformatteerd is?

- Kan ik robots.txt gebruiken om te voorkomen dat zoekmachines toegang krijgen tot gevoelige informatie op mijn website?

- Wat zijn de beste methoden om robots.txt te optimaliseren voor SEO?

- Hoe kan ik robots.txt gebruiken om problemen met dubbele inhoud op mijn website te voorkomen?

- Kan ik robots.txt gebruiken om de toegang tot bepaalde bestandstypen of extensies te blokkeren?

- Wat zijn enkele veelgemaakte fouten die je moet vermijden bij het optimaliseren van robots.txt voor SEO?

- Hoe kan ik robots.txt gebruiken om het crawlbudget van mijn website te verbeteren?

- Kan ik robots.txt gebruiken om zoekmachine crawlers om te leiden naar een andere versie van mijn website, zoals een mobiele versie?

Wat is een robots.txt bestand?

Een robots.txt bestand is een belangrijk onderdeel van elke website die rechtstreeks in contact staat met zoekmachine crawlers, ook wel bots of spiders genoemd. Het is een tekstbestand dat in de hoofdmap van je site staat. Zijn voornaamste doel? Deze bots vertellen welke delen van je site ze moeten crawlen en indexeren, en welke ze moeten negeren.

Met andere woorden, het robots.txt bestand is als een verkeersleider, die de bots van zoekmachines leidt naar de delen die je zichtbaar wilt hebben in de zoekresultaten, en niet naar de delen die je niet zichtbaar wilt hebben. Het is essentieel om te begrijpen dat het robots.txt bestand niet voorkomt dat de gelinkte bronnen direct via een URL toegankelijk zijn; het leidt alleen de crawlers door je website.

Waarom is Robots.txt belangrijk?

Het belang van een robots.txt bestand reikt verder dan alleen maar sturen. Het speelt een belangrijke rol bij het optimaliseren van websites, vooral voor SEO.

1. Crawl budget optimaliseren

Elke zoekmachine kent je website een “crawl budget” toe, dat verwijst naar het aantal pagina’s dat de zoekmachine bot op je site zal crawlen binnen een bepaald tijdsbestek. Als je site enorm groot is met veel pagina’s, wil je ervoor zorgen dat de crawler geen tijd verspilt aan minder belangrijke of irrelevante pagina’s.

Dat is waar je robots.txt bestand om de hoek komt kijken. Door de zoekmachine bots efficiënt naar de essentiële pagina’s te leiden, zorg je ervoor dat ze de waardevolste inhoud crawlen en indexeren binnen het toegewezen crawlbudget. Dit is vooral cruciaal voor grotere websites of e-commerce sites met duizenden productpagina’s.

2. Duplicate & niet-openbare pagina’s blokkeren

Duplicate content kan je SEO inspanningen schaden. Als je site pagina’s heeft met vergelijkbare inhoud, kunnen de bots van zoekmachines in de war raken over welke versie ze moeten indexeren en rangschikken. Met een goed ontworpen robots.txt bestand kun je de bots opdragen deze dubbele pagina’s niet te crawlen.

Evenzo kun je pagina’s op je site hebben die niet bedoeld zijn voor publiek, zoals beheerpagina’s of privémappen. Je kunt het robots.txt bestand gebruiken om te voorkomen dat deze in de zoekresultaten verschijnen, zodat de privégedeelten van je website privé blijven.

3. Bronnen verbergen

Soms zijn er bronnen op je website zoals afbeeldingen, CSS-bestanden of PDF’s die je niet in de zoekresultaten wilt zien. Je kunt deze specificeren in je robots.txt bestand, waarbij je de bots van zoekmachines vraagt deze niet te crawlen of te indexeren. Deze strategie kan nuttig zijn om irrelevante zoekresultaten op afstand te houden en de gebruikerservaring te verbeteren.

Robots.txt syntax

Inzicht in de syntaxis van een robots.txt bestand is essentieel voor een effectieve implementatie. Laten we de belangrijkste richtlijnen en hoe ze te gebruiken eens voor je op een rijtje zetten.

De User-Agent richtlijn

De User-Agent richtlijn wordt gebruikt om aan te geven op welke zoekmachine bot de volgende regels van toepassing zijn. Als je bijvoorbeeld regels wilt instellen voor de bot van Google, begin je met:

User-agent: Googlebot

Als je wilt dat de regels voor alle bots gelden, kun je het jokerteken * gebruiken:

User-agent: *

De meest gebruikte User-Agents zijn:

| Crawler Naam / User Agent | Doel / motor | Officiële homepage |

|---|---|---|

| Googlebot | Zoekmachine, en vele andere diensten | Google crawlers |

| Bingbot | Zoekmachine | Bing crawlers |

| Slurp | Zoekmachine | Yahoo crawlers |

| DuckDuckBot | Zoekmachine | DuckDuckGo crawlers |

| Baiduspider | Zoekmachine | Baidu crawlers |

| Yandexbot | Zoekmachine | Yandex crawlers |

| Sogou Spider | Zoekmachine | Sogou crawlers |

| OkHttp bibliotheek | HTTP-bibliotheek voor Android- en Java-toepassingen | OkHttp |

| Chrome zonder hoofd | Browser bediend vanuit commandoregel/serveromgeving | Headless Chromium |

| Python HTTP-bibliotheek | HTTP-bibliotheken zoals Requests, HTTPX of AIOHTTP | Python Verzoeken |

| cURL | Command line tool en een bibliotheek | cURL |

| Nessus | Kwetsbaarheidsscanner | Nessus |

| FacebookBot | Sociaal netwerk/recensies | Facebook Crawler |

| TwitterBot | Sociaal netwerk/recensies | Twitter Crawler |

| LinkedInBot | Sociaal netwerk/recensies | LinkedIn Crawler |

| ia_archiver | Sociaal netwerk/recensies | Alexa (Amazon) Crawler |

| AhrefsBot | Site- en marketingaudit | AhrefsBot |

| SemrushBot | Site Audit | SemrushBot |

| Chrome-Lighthouse | Browser add-on, auditing | Lighthouse |

| Adbeat | Site- en marketingaudit | Adbeat |

| Comscore / Proximic | Online reclame | Comscore Crawler |

| Bytespider | Zoekmachine | 关于Bytespider |

| PetalBot | Zoekmachine | Petal Zoeken |

De Disallow richtlijn

De Disallow richtlijn wordt gebruikt om bots te vertellen dat ze bepaalde pagina’s of delen van je site niet mogen crawlen. Bijvoorbeeld, om alle bots te beletten een pagina genaamd private.html te crawlen, schrijf je:

User-agent: *

Disallow: /private.html

De toestaan-richtlijn

De Allow richtlijn wordt vooral gebruikt in combinatie met Disallow als je een deel van je site wilt blokkeren, maar toch de toegang tot bepaalde pagina’s binnen dat deel wilt toestaan. Dit geldt alleen voor Googlebot. Bijvoorbeeld:

User-agent: Googlebot

Disallow: /private/

Allow: /private/public.html

De Sitemap-richtlijn

De Sitemap-richtlijn wordt gebruikt om bots te verwijzen naar je XML-sitemap. Deze maakt geen deel uit van de officiële robots.txt specificatie, maar wordt door de meeste grote zoekmachines gerespecteerd:

Sitemap: https://www.example.com/sitemap.xml

Crawl-Delay richtlijn

De Crawl-Delay richtlijn wordt gebruikt om te voorkomen dat servers overbelast raken door een vertraging in te stellen tussen opeenvolgende crawls. Dit wordt niet door alle bots ondersteund:

User-agent: Bingbot

Crawl-delay: 10

Noindex richtlijn

De Noindex-richtlijn wordt gebruikt om te voorkomen dat bepaalde pagina’s in de zoekresultaten verschijnen. Vanaf september 2019 ondersteunt Google deze richtlijn echter niet meer in robots.txt:

User-agent: *

Noindex: /private.html

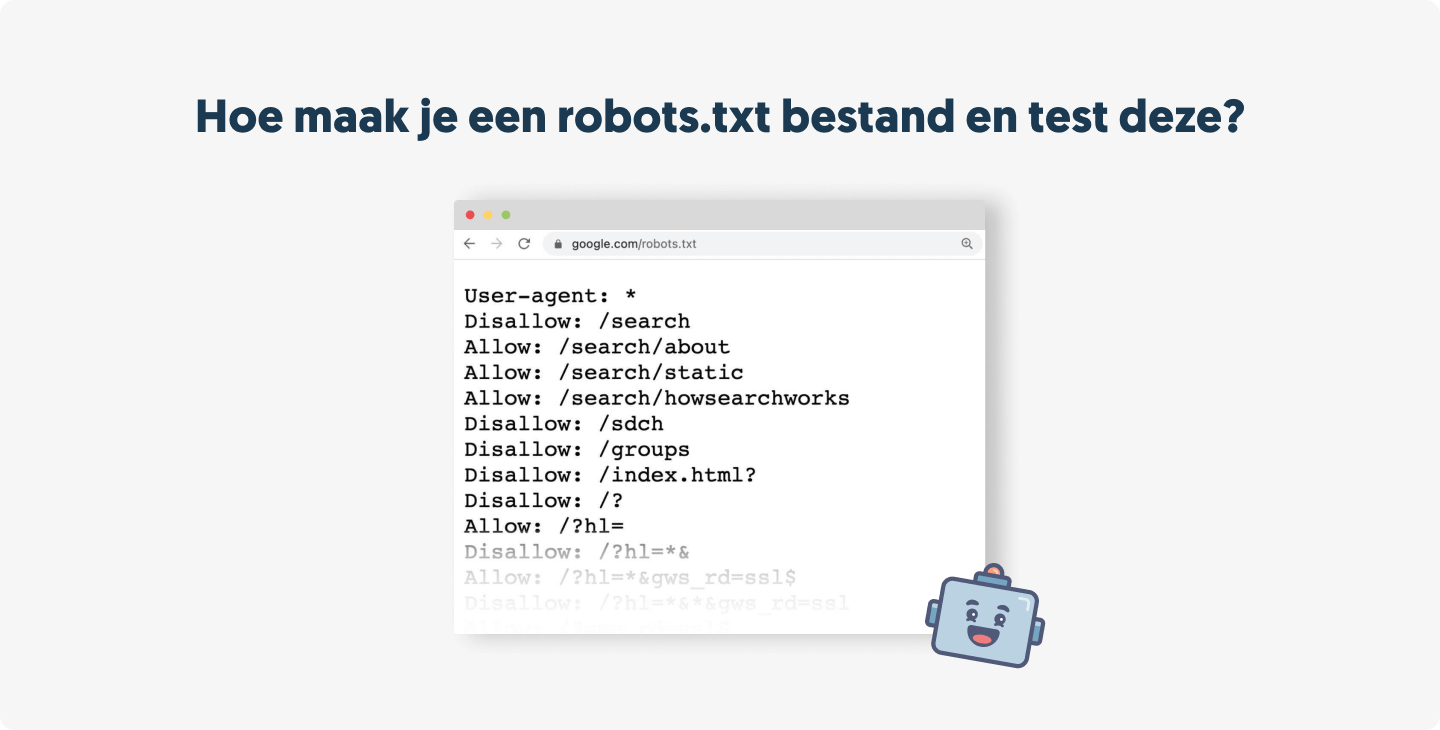

Hoe maak je een robots.txt bestand en test deze?

Het maken van een robots.txt bestand is eenvoudig. Het is een eenvoudig tekstbestand dat je kunt maken met een tekstverwerker zoals Notepad of TextEdit.

Hier is een voorbeeld van een basis robots.txt bestand:

User-agent: *

Disallow: /private/

Allow: /private/public.html

Sitemap: https://www.example.com/sitemap.xml

Dit bestand instrueert alle bots (User-agent: *) om geen pagina’s in de map /private/ te crawlen (Disallow: /private/), behalve public.html (Allow: /private/public.html). Het wijst bots ook naar de XML sitemap (Sitemap: https://www.example.com/sitemap.xml).

Als je eenmaal je robots.txt bestand hebt gemaakt, moet je het uploaden naar de hoofdmap van je site. De URL moet zijn yourdomain.com/robots.txt.

Het is cruciaal om je robots.txt bestand te testen om er zeker van te zijn dat het werkt zoals bedoeld. Google biedt een gratis tool binnen Google Search Console genaamd de Robots Testing Tool. Dit hulpmiddel leest en interpreteert je robots.txt-bestand en wijst op eventuele fouten of waarschuwingen die de werking ervan kunnen beïnvloeden.

Je robots.txt bestand optimaliseren

Een goed geoptimaliseerd robots.txt bestand kan je SEO inspanningen aanzienlijk verbeteren. Hier zijn een paar strategieën:

- Geef prioriteit aan belangrijke pagina’s: Gebruik de Allow en Disallow directives om bots naar je belangrijkste en waardevolste inhoud te leiden.

- Blokkeer onbelangrijke pagina’s: Pagina’s zoals algemene voorwaarden, privacybeleid, of andere juridische pagina’s zorgen doorgaans niet voor waardevol organisch verkeer. Je kunt de Disallow richtlijn gebruiken om te voorkomen dat bots crawlbudget verspillen aan deze pagina’s.

- Neem je sitemap op: Het opnemen van de Sitemap-richtlijn kan zoekmachines helpen je pagina’s efficiënter te ontdekken en te indexeren, vooral bij grotere websites of websites met een ingewikkelde architectuur.

- Gebruik crawl-vertraging verstandig: Als je server overbelast wordt door bots, kan een Crawl-Delay richtlijn helpen. Gebruik dit echter spaarzaam en alleen als het nodig is, want het kan je totale crawl-budget verminderen.

- Beheer dubbele inhoud: Als je site gebieden met dubbele inhoud heeft, kun je de richtlijn Disallow gebruiken om te voorkomen dat deze secties worden gecrawld en geïndexeerd, waardoor potentiële verwarring voor zoekmachines wordt verminderd.

Robots.txt Best Practices

Nu je weet hoe je je robots.txt bestand moet maken, testen en optimaliseren, laten we eens kijken naar een aantal best practices.

Gebruik nieuwe regels voor elke richtlijn

Elke richtlijn in je robots.txt bestand moet op een nieuwe regel staan. Door deze indeling kunnen bots het bestand efficiënter lezen en begrijpen. Bijvoorbeeld:

User-agent: *

Disallow: /private/

Allow: /private/public.html

Gebruik elke user-agent één keer

Elke user-agent mag maar één keer genoemd worden in je robots.txt bestand. Alle richtlijnen voor die user-agent moeten worden gegroepeerd. Deze aanpak voorkomt mogelijke conflicten en vereenvoudigt het bestandsbeheer. Bijvoorbeeld:

User-agent: Googlebot

Disallow: /private/

Allow: /private/public.html

User-agent: Bingbot

Disallow: /private/

Wildcards gebruiken om aanwijzingen te verduidelijken

Het jokerteken * kan worden gebruikt om met elke willekeurige reeks tekens overeen te komen. Het kan vooral nuttig zijn wanneer je de toegang tot een groep URL’s wilt weigeren of toestaan. Bijvoorbeeld, Disallow: /*.html zou alle HTML bestanden blokkeren.

Gebruik “$” om het einde van een URL aan te geven

Het dollarteken $ kan worden gebruikt om het einde van een URL aan te geven. Bijvoorbeeld, Disallow: /*.php$ zou alle URL’s blokkeren die eindigen op .php.

User-agent: *

Disallow: /*.php$

Gebruik de Hash (#) om commentaar toe te voegen

Het hash symbool # kan gebruikt worden om commentaar toe te voegen aan je robots.txt bestand. Commentaar kan gebruikt worden om het doel van specifieke regels uit te leggen of om andere nuttige informatie te geven. Bijvoorbeeld:

# Block all bots from private directory

User-agent: *

Disallow: /private/

Gebruik aparte robots.txt bestanden voor verschillende subdomeinen

Als je website verschillende subdomeinen heeft, moet elk zijn eigen robots.txt bestand hebben. Zo kun je voor elk subdomein specifieke crawl-instructies maken. Het robots.txt bestand voor blog.example.com kan bijvoorbeeld anders zijn dan dat voor shop.example.com.

Conclusie

Met deze uitgebreide gids hebben we de moeren en bouten van een robots.txt bestand onderzocht en de belangrijke rol ervan in SEO belicht. Van het begrijpen van de syntaxis tot het optimaliseren van het gebruik ervan voor je website, we hebben je de fundamentele kennis gegeven die je nodig hebt om robots.txt effectief te gebruiken.

Het beheren van een robots.txt bestand is echter maar één facet van SEO. De wereld van zoekmachine optimalisatie is groot en evolueert voortdurend. Van zoekwoordenonderzoek en content marketing tot technische SEO en linkbuilding, er is veel om bij te houden.

Bovendien is elk bedrijf uniek, en dus ook zijn SEO behoeften. Wat werkt voor de ene website is misschien niet zo effectief voor een andere. Deze realiteit onderstreept het belang van een SEO strategie op maat, die rekening houdt met de specifieke doelen en uitdagingen van je bedrijf.

Als je deze gids hebt doorgelezen en je overweldigd voelt, maak je dan geen zorgen – je bent niet alleen. SEO kan complex zijn, en het is oké om hulp te vragen. Als je onzeker bent over je robots.txt bestand of een ander aspect van je SEO, zijn we er om je te helpen.

Bij User Growth zijn we gespecialiseerd in het helpen van bedrijven om hun zoekmachine rankings te verbeteren en meer verkeer naar hun sites te leiden. Ons team van SEO experts kan je robots.txt-bestand bekijken, een uitgebreide SEO-audit uitvoeren en een aangepaste strategie ontwikkelen om je bedrijf te helpen groeien.

Vergeet niet dat effectieve SEO een marathon is, geen sprint. Het kost tijd, geduld en consequente inspanning. Maar met de juiste strategieën en deskundige begeleiding kun je je website beter zichtbaar maken voor je doelgroep, meer verkeer aantrekken, en uiteindelijk je bedrijf laten groeien.

Wil je meer weten? Vul het onderstaande contactformulier in. Laten we het gesprek aangaan over hoe we je SEO inspanningen kunnen ondersteunen en je bedrijf online kunnen laten floreren.

Veelgestelde vragen over Robots.txt

Wat is robots.txt, en hoe werkt het?

Robots.txt is een eenvoudig tekstbestand in de hoofdmap van je website dat webrobots (meestal zoekmachinebots) instrueert hoe ze pagina’s op je website moeten crawlen. Het legt regels vast die bots moeten volgen wanneer ze verschillende delen van je site bezoeken, en geeft aan welke pagina’s ze moeten crawlen en welke ze moeten negeren.

Hoe kan robots.txt mij helpen de toegang van zoekmachine-crawlers tot mijn website te controleren?

Robots.txt gebruikt richtlijnen als “Disallow” en “Allow” om bots te leiden. Als er delen van je site zijn die je liever niet door bots wilt laten crawlen (bijvoorbeeld dubbele pagina’s of backend mappen), dan kun je die in het robots.txt bestand aangeven.

Wat zijn de voordelen van het gebruik van robots.txt, en hoe kan het de SEO van mijn website verbeteren?

Met robots.txt kun je het crawlbudget van je site optimaliseren, door bots te blokkeren voor onnodige of dubbele pagina’s en ze naar belangrijke pagina’s te leiden. Dit zorgt ervoor dat zoekmachines je waardevolle inhoud efficiënter indexeren, waardoor je SEO rankings mogelijk verbeteren.

Kan robots.txt gebruikt worden om specifieke zoekmachines of bots te verhinderen mijn website te crawlen?

Ja, door een bepaalde User-Agent op te geven in je robots.txt bestand, kun je de toegang voor verschillende bots regelen. Denk er echter aan dat niet alle bots het robots.txt bestand respecteren.

Wat zijn veel voorkomende fouten die je moet vermijden bij het maken van een robots.txt bestand?

Enkele veel voorkomende fouten zijn het per ongeluk blokkeren van alle bots, het verhinderen van het crawlen van essentiële bronnen, en typefouten of onjuiste syntaxis die tot fouten leiden. Onthoud ook dat robots.txt geen privacy garandeert; gebruik andere methoden om gevoelige gegevens te beveiligen.

Wat gebeurt er als ik geen robots.txt bestand op mijn website heb?

Als je geen robots.txt bestand hebt, zullen zoekmachine bots aannemen dat ze alle pagina’s van je website kunnen crawlen en indexeren.

Hoe test ik mijn robots.txt bestand om er zeker van te zijn dat het correct werkt?

Je kunt je robots.txt bestand testen met hulpmiddelen zoals Google’s Robots Testing Tool. Dit hulpmiddel helpt bij het opsporen van fouten en controleert of de richtlijnen werken zoals bedoeld.

Kan ik robots.txt gebruiken om te voorkomen dat specifieke pagina’s of delen van mijn website door zoekmachines worden geïndexeerd?

Ja, je kunt de “Disallow” richtlijn in je robots.txt bestand gebruiken om te voorkomen dat bots specifieke pagina’s of secties crawlen. Maar voor meer granulaire controle kun je overwegen een noindex meta tag of X-Robots-Tag HTTP header te gebruiken op de specifieke pagina’s.

Hoe kan ik mijn robots.txt bestand aanpassen aan veranderingen in de structuur of inhoud van mijn website?

Bewerk gewoon het robots.txt bestand en pas de “Disallow” en “Allow” directives aan waar nodig. Vergeet niet het bijgewerkte bestand te testen om er zeker van te zijn dat het correct werkt.

Wat is het verschil tussen “allow” en “disallow” directives in robots.txt?

De “Disallow” richtlijn vertelt bots dat ze een specifieke URL of patroon van URL’s niet mogen crawlen, terwijl de “Allow” richtlijn bots toegang geeft tot een URL of patroon van URL’s, zelfs binnen een afgekeurde bovenliggende map.

Hoe kan ik wildcards in robots.txt gebruiken om de toegang tot meerdere URL’s of mappen te blokkeren of toe te staan?

Je kunt een sterretje (*) gebruiken als jokerteken voor een willekeurige reeks tekens, en een dollarteken ($) voor het einde van een URL.

Wat is de syntaxis voor robots.txt, en hoe kan ik ervoor zorgen dat het goed geformatteerd is?

Een robots.txt bestand gebruikt een eenvoudige syntaxis. Elke regel bestaat uit een user-agent regel om de bot te specificeren, gevolgd door “Disallow” en/of “Allow” regels om de richtlijnen in te stellen. Gebruik een validatietool om ervoor te zorgen dat je bestand correct geformatteerd is.

Kan ik robots.txt gebruiken om te voorkomen dat zoekmachines toegang krijgen tot gevoelige informatie op mijn website?

Hoewel je robots.txt kunt gebruiken om bots te ontmoedigen bepaalde pagina’s te crawlen, is het geen veilige methode om gevoelige gegevens te beschermen. Elke gebruiker kan je robots.txt bestand bekijken, en sommige bots kunnen ervoor kiezen het te negeren. Gebruik voor gevoelige gegevens veiligere methoden zoals wachtwoordbeveiliging of noindex directives.

Wat zijn de beste methoden om robots.txt te optimaliseren voor SEO?

Best practices zijn het gebruik van duidelijke directives voor elke bot, het blokkeren van dubbele pagina’s, het optimaliseren van je crawl budget, en het effectief gebruik van wildcards en end-of-line indicatoren. Vergeet ook niet je bestand bij te houden naarmate je site zich ontwikkelt.

Hoe kan ik robots.txt gebruiken om problemen met dubbele inhoud op mijn website te voorkomen?

Je kunt de “Disallow” richtlijn gebruiken om bots te verhinderen dubbele pagina’s op je site te crawlen. Vaak is het echter beter om problemen met dubbele inhoud bij de bron aan te pakken, bijvoorbeeld door canonieke tags te gebruiken.

Kan ik robots.txt gebruiken om de toegang tot bepaalde bestandstypen of extensies te blokkeren?

Ja, je kunt de “Disallow” richtlijn met wildcards gebruiken om bots de toegang tot URL’s die eindigen op specifieke extensies te blokkeren. Als je bijvoorbeeld alle .jpg en .png afbeeldingsbestanden wilt blokkeren voor bots, zou je robots.txt bestand de volgende regels kunnen bevatten:

User-agent: *

Disallow: /*.jpg$

Disallow: /*.png$

In dit voorbeeld is het sterretje (*) een jokerteken dat overeenkomt met elke willekeurige reeks tekens, en het dollarteken ($) geeft het einde van een URL aan. Daarom zal /*.jpg$ overeenkomen met elke URL die eindigt op .jpg, waardoor bots effectief de toegang tot je .jpg-afbeeldingsbestanden blokkeren. Hetzelfde geldt voor .png bestanden. Wees voorzichtig met deze methode, want het kan voorkomen dat afbeeldingen verschijnen in de zoekresultaten voor afbeeldingen.

Wat zijn enkele veelgemaakte fouten die je moet vermijden bij het optimaliseren van robots.txt voor SEO?

Veel voorkomende fouten zijn het per ongeluk blokkeren van alle bots, het niet toestaan van essentiële bronnen, het gebruik van onjuiste syntaxis, en het vertrouwen op robots.txt voor privacy of om problemen met dubbele inhoud aan te pakken.

Hoe kan ik robots.txt gebruiken om het crawlbudget van mijn website te verbeteren?

Je kunt je crawlbudget optimaliseren door robots.txt te gebruiken om bots weg te leiden van onbelangrijke of dubbele pagina’s en naar je belangrijkste inhoud. Dit zorgt ervoor dat zoekmachines hun tijd besteden aan het crawlen van de pagina’s die het belangrijkst zijn voor de zichtbaarheid van je site.

Kan ik robots.txt gebruiken om zoekmachine crawlers om te leiden naar een andere versie van mijn website, zoals een mobiele versie?

Nee, robots.txt kan niet worden gebruikt voor omleiding. Om bots naar verschillende versies van je site te leiden (bijvoorbeeld desktop en mobiele versies) kun je andere methoden gebruiken, zoals rel=”alternate” tags of HTTP-headers.